MIT新晋副证明何恺明神秘顾客营运,新作簇新出炉:

对准一个横亘在AI发展之路上十年之久的问题:数据集偏差。

该筹商为何恺明在Meta本事与刘壮劝诱完成,他们在论文中指出:

尽管往日十多年里业界为构建更大、更千般化、更全面、偏差更小的数据集作念了好多接力,但当代神经网罗似乎越来越善于”看透”并诓骗这些数据纠合暗藏的偏差。

这不禁让东谈主怀疑:咱们在摈斥数据集偏差的接触中,真的取得了胜利吗?

数据集偏差之战,在2011年由著名学者Antonio Torralba和Alyosha Efros建议——

Alyosha Efros恰是Sora两位一作博士小哥(Tim Brooks和William Peebles)的博士导师,而Antonio Torralba也在本科本事换取过Peebles。

其时他们发现,机器学习模子很容易“过拟合”到特定的数据集上,导致在其他数据集上推崇欠安。

神秘顾客_赛优市场调研十多年往日了,尽管咱们有了更大、更千般化的数据集,如ImageNet、YFCC100M、CC12M等,但这个问题似乎并莫得得到根柢处理。

反而,跟着神经网罗变得越来越强大,它们“挖掘”和诓骗数据集偏差的才调也越来越强了!

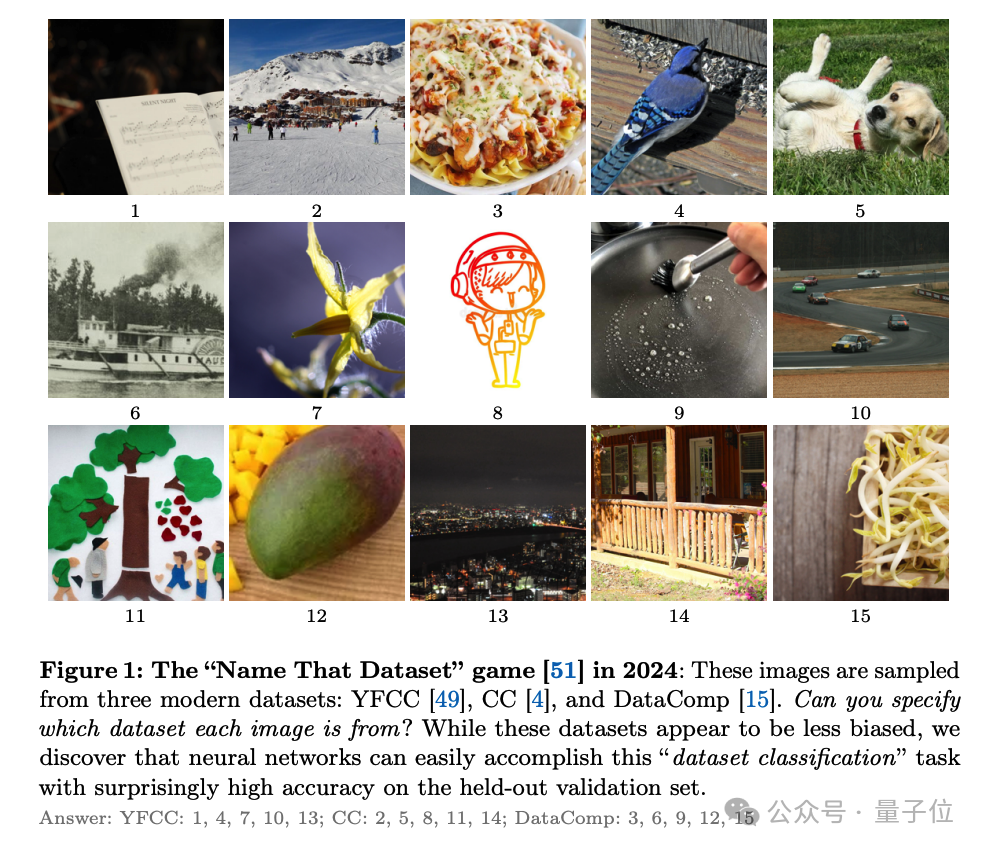

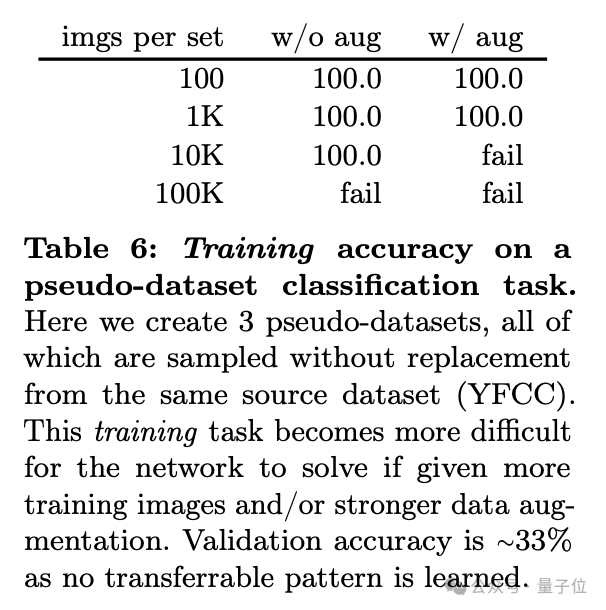

为了分析这个问题,何恺明团队打算了一个臆造的”数据集分类”任务。

听名字你可能就猜到了:给定一张图像,模子需要判断它来自哪个数据集。通过看模子在这个任务上的推崇,就不错了解它们捕捉数据集偏差的才调。

1、设定调查目标:明确调查的目的和期望结果,例如评估销售过程、售后服务质量或员工表现等方面。

当代AI大要看透不同数据集

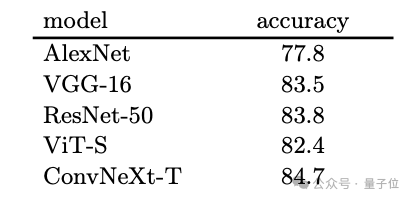

在实践中团队发现,千般当代神经网罗架构,如AlexNet、VGG、ResNet、ViT等,在数据集分类任务上推崇出惊东谈主的一致性:它们险些齐能以越过80%的准确率鉴识不同数据集的图像!

更令东谈主吃惊的是,这个发当今千般不同的条目下齐颠倒庄重:

非论是不同的数据集组合、不同的模子架构、不同的模子尺寸、不同的检会数据量,如故不同的数据增强尺度,神经网罗永久能大要”一眼看透”图像的数据集开始。

那么,神经网罗是怎样作念到这少量的呢?是靠单纯的记挂,如故学到了一些更普适的规则?

为了揭开答案,团队作念了一系列对比实践。他们发现,要是把不同的数据集就地混在一谈,神经网罗就很难再鉴识它们了(准确率下跌到了33%)。这阐发,神秘顾客新闻神经网罗并不是在单纯地记挂每一张图像,而是真的学到了一些数据集私有的形状。

更道理道理的是,即使在自监督学习的缔造下,神经网罗也展现出了惊东谈主的”数据集辨识力”。在这种缔造下,模子在检会时并没灵验到任何数据集的标签信息,但当在这些自监督学习到的特征上检会一个肤浅的线性分类器时,它依然能以越过70%的准确率鉴识不同的数据集!

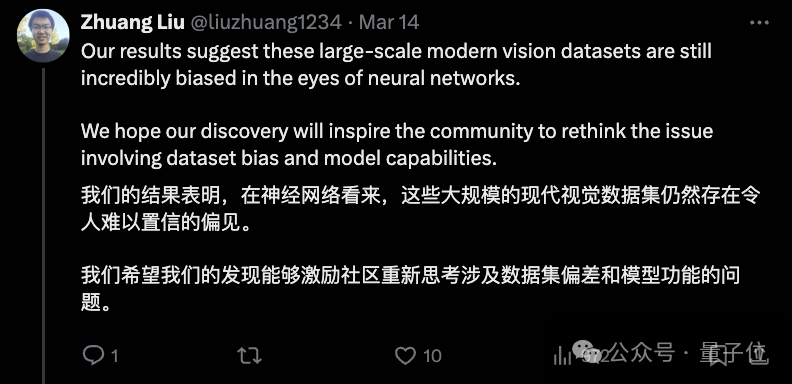

通过这一系列的实践,何恺明、刘壮等东谈主的筹商给咱们敲响了警钟:尽管这十年咱们一直在接力构建更大、更千般化的数据集,但数据集偏差这个问题似乎并莫得得到根柢处理。相背,当代神经网罗越来越善于诓骗这些偏差来获取高准确率,但这可能并不代表它们真实学到了鲁棒、普适的视觉办法。

论文的终末,作家号召扫数这个词AI社区再行注释数据集偏差这个问题,并再行念念考如安在算法和数据两个层面上来支吾这一挑战。

CVPR最好论文作家的通力劝诱

本文是何恺明在Meta本事,与Meta筹商科学家刘壮劝诱完成。

当今,何恺明也曾追究在MIT上岗,担任电气工程与计较机科学系的助理证明。他的“开学第一课”开课即火爆,在youtube上也曾有2.9万的播放量。

和何恺明相同,刘壮本科毕业自清华,而且亦然CVPR最好论文奖得主——他是CVPR2017最好论文DenseNet的第一作家。

2017年,刘壮从清华姚班毕业,参加加州大学伯克利分校攻读博士学位,师从Trevor Darrell,是贾扬清的同门师弟。

博士毕业后,刘壮参加Meta AI Research职责。在此之前,他也曾在Meta实习了一年多时辰,本事和谢赛宁劝诱,发表了ConvNeXt。